AI幻觉,简单来说,是指人工智能系统(自然语言处理模型)生成的内容与真实数据不符,或偏离用户指令的现象,就像人类说“梦话”一样~* p, j7 x: q1 f3 o9 l

1 f- k7 d: J. F- T! ~# o) ?; d

zpmfi1pfciw64013564718.png

$ M9 `7 z% U& L4 R2 ?

$ M9 `7 z% U& L4 R2 ?

那么AI幻觉有哪些?是什么原因产生的?我们该如何避免AI幻觉呢?

3 R# W. K8 F8 r/ N0 w

bfc4zcfcpkh2_1213564818.png

9 T& F8 g% x: M d

9 T& F8 g% x: M d

1" t6 I. L' h1 |4 o* O

AI会产生什么样的幻觉?

3 H" M) w/ C! r! \- u1 z. Y3 [

7 \5 x" c2 Q9 c8 a可能有的小伙伴说:“我知道了!AI‘胡说八道’就是AI幻觉呗?”其实也没这么简单,AI幻觉主要有两类。

2 T/ f+ n/ a- y; m事实幻觉:“假新闻制造机”4 F, [- B' o \) z% g6 a! ~0 ]

A:事实不一致:AI生成的内容与现实世界事实相矛盾+ p5 [& u s* h

rjjugz5kou164013564918.png

- k8 E, o3 ]) a. n

- k8 E, o3 ]) a. n

当被问及“世界上最高的山峰是哪座?”,如果AI回答“深圳塘朗山是世界上最高的山峰。”这就是一个事实不一致的例子,因为塘朗山坐落于广东省深圳市,海拔430米远低于珠穆朗玛峰8848.86米,这个回答与现实世界的事实相矛盾。5 }& Q9 ^! O9 U: s+ t3 E

B:事实捏造:AI生成完全虚构的内容: E, x+ T3 l3 m2 M7 Z% r

' m$ ` |! k) ?) i; f# d6 g }

xcnqg3gbzo164013565018.png

) X+ G k+ U6 Q% z" v5 r如果AI描述说“2024年,考古学家在埃及金字塔内发现了一座隐藏的密室,里面藏有古代法老的宝藏和未知的高科技装置。”这就是完全虚构的信息,截至目前没有考古发现或科学证据表明埃及金字塔内存在未被发现的密室,更不用说藏有古代法老的宝藏或未知的高科技装置了。

! S, y5 h; ?" H, I忠诚度幻觉:“指令迷失”+ B$ C7 R$ _: t# W

A:指令不一致:AI的回答偏离用户的要求

6 X( d! n |: V& D6 F$ |1 ?* K) C; R5 D4 s: O; G% {, ~' `

swa45i2tfsa64013565118.png

& ]1 c: x0 d6 g8 g# C* O

& ]1 c: x0 d6 g8 g# C* O

如果用户要求AI“讲解一下龙飞凤舞”,但AI回答了“老铁,我给你搜了几段舞蹈教学” ,这就完全偏离了原始的问题。

% [& w: S0 t* mB:上下文不一致:AI生成的内容与提供的背景信息不符

- }! n+ N6 D* j1 w) b, B

44z5xxldxdp64013565218.png

7 J% y9 o' A# O! i: _

7 J% y9 o' A# O! i: _

假设在一个讨论中国传统节日的上下文中,用户问:“春节是什么时候?”AI回答:“春节是中国农历新年,通常在每年的1月或2月庆祝。”这个回答是正确的,符合春节的基本情况。% {. x! m% u* O) w$ Y( }

然而,如果AI接着说:“春节是纪念屈原的节日,人们会吃粽子和赛龙舟。”这就是上下文不一致的例子,因为AI的回答与春节的背景信息不符。" b9 w) L# E P, s- U

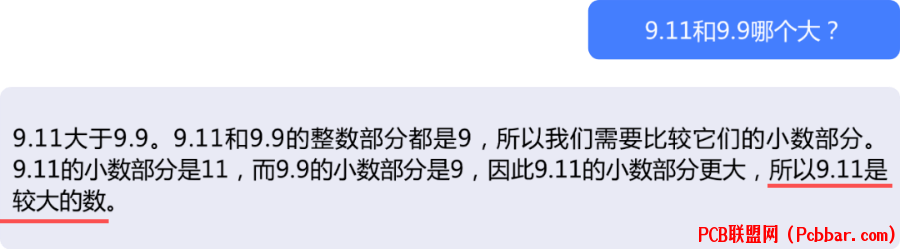

C. 逻辑不一致:AI的输出存在内在逻辑矛盾9 h9 N) ~( ^7 T. r

开头的9.11大于9.9就是一个典型的数值计算逻辑混乱的例子……,AI把自己绕蒙了~

7 P b% o* g6 B! G7 v g1 \; ]5 s# r1 a

4 e) K* j4 j% O3 c ^" \: i3 d2

% E$ l4 V! d9 R* \4 OAI幻觉有哪些特点

7 [$ O' p# [6 \

6 q' `/ @- L& ^& S. j内容流畅性:尽管内容可能有误,AI生成的文本通常仍然连贯流畅。表面合理性 :生成的内容表面上看起来可信,给人以“这看起来很对”的第一印象,非专业人士难以辨别。上下文相关 :AI的幻觉内容并非凭空出现,它们通常与特定的上下文情境紧密相关。不可预测性 :很难预测AI何时会产生幻觉,可能幻觉也很难复现,就像人很难在今天做一个与昨天相同的梦。

, _4 u: w4 W$ h4 j2 u37 N/ o$ y: Y* y/ F+ I

AI幻觉的“幕后黑手”1 D# t- A8 J5 y

+ t) M4 V4 C3 D+ l0 }AI幻觉主要来自以下方面:数据里的“坑”) Z7 M6 _0 x: D" }

0lu5d32d4d364013565318.png

+ u0 p0 L' h3 \1 S

+ u0 p0 L' h3 \1 S

训练数据局限:AI训练数据可能包含错误、偏见或过时信息。就像教小朋友学习,课本是错的,考试自然无法答对。缺乏实时更新:AI通常基于静态数据训练,无法及时获取最新信息。考试要根据最新的资料复习,拿一本82年的教材是考不了24年的高考的~

3 ]0 f, u' x; D) B

15nlv5jblhi2_0513565418.png

% L: K5 t2 J7 `

2 p* Y4 z- f ^! ]- L" D训练过程的“小插曲”

. ?; ?( g8 g C+ S) h: K+ `6 c& M6 c4 {5 {) f% e. Z* e

2tu2cuwfrah64013565518.png

- Q0 i" a- z1 {3 ?7 H

- Q0 i" a- z1 {3 ?7 H

过度泛化 :模型可能过于依赖某些模式,导致在新情况下推导错误。就像我们学习时候只记住了公式,却不会灵活变通。上下文理解不足:AI可能无法完全把握复杂的上下文关系。在处理多个复杂信息点,或者在推理时容易出错。就像我们的大脑有时也会短路一样。0 P2 B9 Z5 d+ D* N0 N) c

" t+ U. }+ V6 N! |

模型本身的“小缺陷”: L/ X1 ~( v7 P# N2 b! [

/ K# r2 H/ I% G. U5 X) l8 j

vc4rcxf53ol64013565618.png

* U4 q' j: @; J# ^2 I- z1 Y

* U4 q' j: @; J# ^2 I- z1 Y

模型结构限制:AI通过统计模式预测,但可能无法真正理解信息。“你以为他真的懂你,其实也不过是基于复杂算法的数学而已~”

. s- `5 D) Q4 m5 v6 I4

! m* b- k! Y( g$ w

8 Q0 f3 S- p' ^0 p& r如何避免AI幻觉?- E' K$ c% e" M( I; r$ n

( `" _8 }: y/ \3 Y- x避免AI幻觉有以下几个“绝招”,各位少侠看“自身功力”,酌情修炼~一. 提示工程有策略提示工程通过优化AI的输入提示,使生成的内容更准确。) L4 V! E' `, c/ h1 b8 O7 w) s, g# ]

A. 检索增强生成(RAG)技术

9 p7 H6 z2 S# }! u5 e' F5 A7 r

4fr33s444ic64013565718.png

" F2 Z/ x/ D# R8 g9 nRAG技术通过引入外部知识来帮助AI生成更准确的内容。主要方法包括:0 w0 A4 {/ z) Y9 }/ W( Q1 O

生成前检索:在内容生成前,系统会预检索相关背景信息,为生成过程打下坚实的基础。6 ~! n: i6 _6 P5 y' v) B: z

生成过程中检索:在生成过程中,系统实时检索并整合外部知识,确保内容的时效性和深度。: \; {& b9 ^$ N }) G& j$ l

生成后检索 :生成后,系统再次检索,与现有证据进行对比,验证生成内容的准确性。

4 T, k. Y" p1 W

+ l8 x- Y! Z5 |6 Y& ?' w2 P例如,当AI被问到“2024年登月的宇航员有哪些?“时,RAG系统会先检索最新的新闻信息,然后基于检索到的准确信息生成回答。3 v+ |! e6 D$ P1 q; d" t7 @' J

8 l$ j, z5 B2 u+ o( i i# D

B. 基于反馈和推理的自我改进机制! x9 O ^6 b! V: Z# ~: ]) h

这种方法赋予AI自我反思的能力,使其能够不断优化生成的内容。

+ i' B/ D* p5 d% a5 ~! |* S3 J0 G8 L! A/ I

grzqozroywl64013565818.png

4 u# T7 k) ?( }1 C9 J% T

4 u# T7 k) ?( }1 C9 J% T

AI在生成答案后,会进行自我审视,提出疑问:“这个答案是否全面?是否有关键信息被忽略?”

T' ^5 x: C) x, X3 gC. 提示词的精细化调优* \ p% K& X \+ }( U

通过精心设计的提示词,引导AI生成更可靠、更精确的内容。

+ E. y2 j: v9 _7 K6 q9 e) E) g- |4 U' B. R$ d& I

encqtl1sq2564013565918.png

" A5 ?" J2 u4 x) K' G6 t& j/ v4 J: V0 O

" A5 ?" J2 u4 x) K' G6 t& j/ v4 J: V0 O

例如,在地图导航的AI应用中,使用“请根据最新的交通管制政策、路况信息、天气情况,提供明天上午九点到深圳湾公园的路线推荐,分别提供驾车与公共交通的路线信息,用时推荐等”具体提示,代替笼统的“如何去深圳湾公园”。1 u9 o+ [/ p1 E7 A

这种方法不仅提升了信息的全面性,也增强了AI回答的针对性。(这不仅是我们最容易实现的策略,也是最直观有效的方法,能够显著改善内容生成的质量和深度。! d( {6 m- q' K: O

tjvlggz4eef2_0613566019.png

- p' j9 m K% ?" `)( e( S+ f0 E8 a* [

二. 模型开发不能停AI模型与训练过程的不断进化是减少幻觉产生的关键。6 r4 O5 r5 h1 i5 T* W( w2 n

5 ?$ [8 V' d3 `: t& SA. 创新解码技术2 X3 L$ t5 O" t, e- y1 G

采用新的解码策略,以便更精准地处理语言上下文,例如上下文感知解码(CAD)。

( a5 Q$ y& M: }% E& B/ | x7 l4 J

ddaagb0yqfw64013566119.png

3 z0 f8 |9 @( A/ e. J4 q

3 z0 f8 |9 @( A/ e. J4 q

这种方法通过在解码过程中引入上下文信息,鼓励模型更多地关注所提供的上下文,而不是仅仅依赖于模型在预训练阶段学到的知识。

; F- G6 F, i! V* s; L2 L$ C; ^/ }: p; J1 s

例子:在翻译一部科幻小说时,传统模型可能会直译“Beam me up”为“把我光束上去”,而应用CAD的模型会理解这是一句要求传送的指令,正确翻译为“把我传送上去”。8 a: x# M/ @7 M+ v- {, i

5 [0 I( V9 N* r$ w' C( q9 r

( N: ^% |2 \! G; E1 MB. 知识图谱的应用

% E8 U/ z) S! a. G通过知识图谱,我们能够丰富AI的知识库,让生成的内容更加准确和有深度。6 r! o. p# r# O/ q

keos5bsrbkp64013566219.png

. |8 I/ u' V" w9 R

. |8 I/ u' V" w9 R

想象一下,知识图谱就像一个巨大的、互联的“社交网络”,但它不是连接人,而是连接各种信息和概念。每个“用户”在这个网络中都是一个实体,比如人、地点、事物或者概念。

$ ~/ h% ~ g! {: u+ M. E$ `( {) M8 t1 z Q0 D

它们通过各种“关系”相互连接,就像社交软件上的好友关系一样。知识图谱通过这种方式组织信息,就像一个超级学霸帮助AI快速找到信息,并且理解不同信息之间的联系。

% t2 K* J2 _4 J" ]! O: \# X% a/ u9 @% C) R

举个例子,如果你在知识图谱中查找“苹果”,它不仅会告诉你苹果是一种水果,还可能告诉你苹果公司是一家科技公司,甚至还会告诉你牛顿被苹果启发发现了万有引力。 ]4 j- M1 n6 y* p+ d3 j

/ o% V0 T7 [, Q# m$ M( v, M' `

+ Z6 ?, W/ }% I

C. 基于忠实度的损失函数$ x3 X- i5 M! n& s( ?

引入新的损失函数,对偏离原始数据的生成内容进行惩罚,以减少不准确的信息,从而把AI从幻觉中“掐醒”。

% C2 I% N3 t) x! O- P( ^! l4 y& B5 w- r* G

atbxsjnsezo64013566319.png

: d7 E# Q [3 X" E' C举个例子,AI在生成文章摘要时,如果回答中添加了原文中未提及的内容,损失函数会提高惩罚,确保模型学习到生成与原文相符的内容。

) U* |" k' }( C# m8 o8 C

/ Z7 i. ?; V7 |, X7 @5 C9 Y$ p$ h: t

D. 监督微调9 X0 \& v2 \: T

通过特定领域的数据进行微调,提升模型在特定任务上的准确性。& M9 e: A8 z) z

. d4 i; n0 F8 c4 B# R# |

oxhgbc10kro64013566419.png

) y5 `6 @$ H# h' }& m

) y5 `6 @$ H# h' }& m

举个例子,一个通用的语言模型可能对通信术语理解有限。通过使用大量通信行业资料进行训练微调,可以显著提高模型在通信领域的准确性。

7 A. F% W; ?; X& F比如,它可以更准确地区分相似通信术语的区别,如EBGP和IBGP。/ l+ d; q3 C7 d$ y8 u

4 [5 C3 ~$ S8 A6 f( S: E

三. AI Agent为模型加BuffAI Agent有特定的能力可以提高模型的可靠性,通过这种方式,AI Agent能够更好地理解和处理复杂的任务,减少在生成文本时出现的错误或不准确的信息。

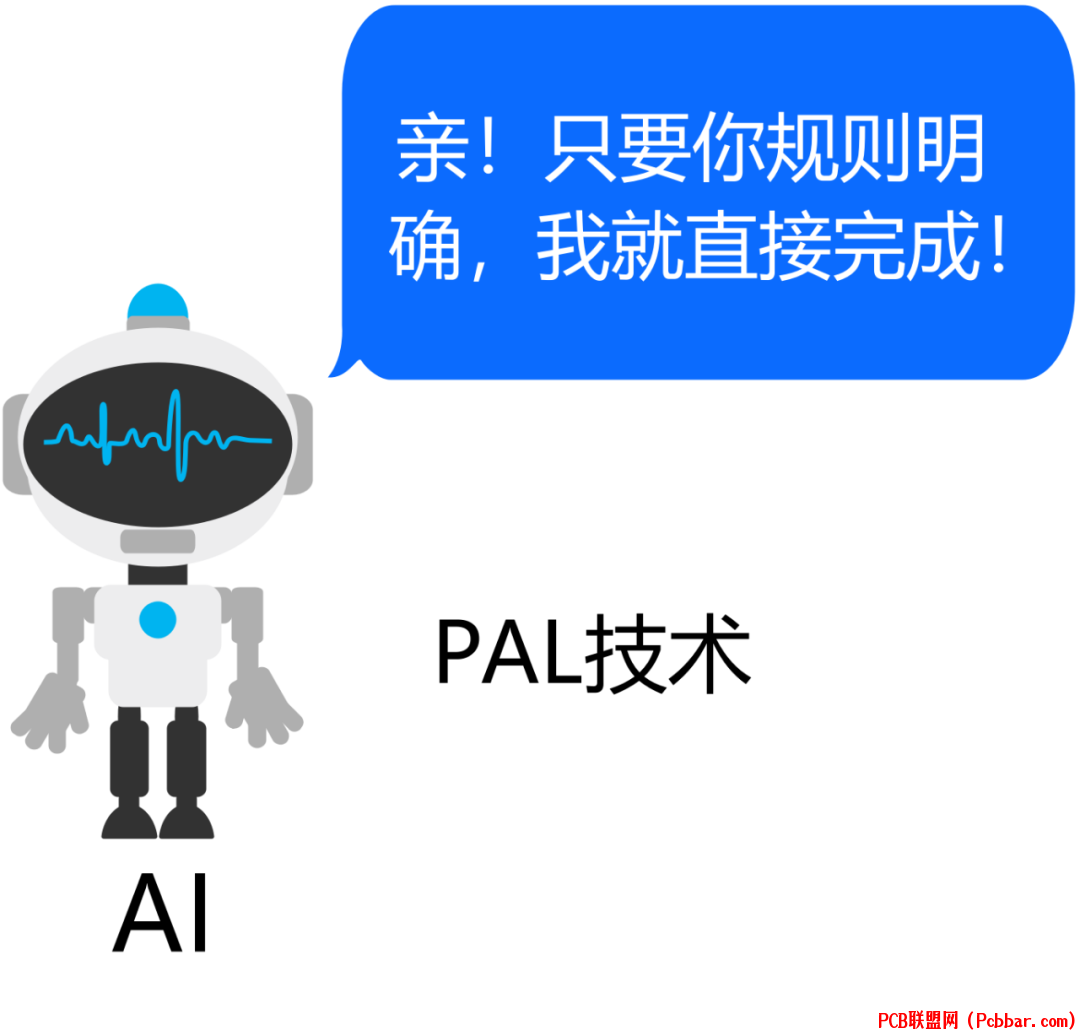

/ _* e7 ~4 k, d8 d3 f( p3 o IA. PAL(Program-Aided Language Models,程序辅助语言模型):PAL技术通过将程序化逻辑嵌入到语言模型中,使得AI能够执行特定的程序或算法来完成任务。4 C: s3 E8 p' R( @/ P7 H

PAL技术像是一个“自动化工具”,它通过内置的程序逻辑来指导AI系统如何完成任务。这种技术的优势在于能够处理那些规则明确、步骤固定的任务。

& ]$ p5 @: U1 R( |3 N) S# Z

i304x2nkbyj64013566519.png

9 ^: c7 s( c. t4 R% C举个例子,如果你告诉基于PAL技术的AI系统:“我需要在每天下午3点提醒我喝水。”系统会设置一个自动化的日程提醒,每天按时提醒你,而不需要进一步的交互。. M" w7 [, H. K6 \1 \" @0 R

, v7 |( E+ |* R4 W9 E j3 c. ~

g4bsldkggfu64013566619.png

, g9 l. q2 y: {

, g9 l. q2 y: {

B. ReAct(Reasoning and Acting,推理与行动):

7 k0 c* }4 P: I) F8 Q: KReAct技术强调AI对上下文的理解,以及基于这种理解进行的推理和决策。- ^4 K9 f8 [# y( S% J( A* }

}/ H6 z' d: G; ~8 V

ReAct技术更像是一个“智能助手”,它不仅理解用户的请求,还能够根据请求的内容进行推理,并采取相应的行动。这种技术的优势在于能够处理那些需要灵活推理和决策的任务。# E9 o+ `5 J( U

/ }6 P% j( {% n6 [1 r$ |# ?6 {. v3 t举个例子,如果你告诉基于ReAct算法的AI系统:“我明天有个会议,需要准备一份报告。”ReAct系统会理解你的请求,然后推理出你需要的信息类型,可能会询问你报告的具体内容和格式,然后根据这些信息来帮助你准备报告。. n# g$ L i9 a v, r: V( }3 {

4 t! H4 H" n& r: R5 e$ L# I- c

2 _. X8 w, z- o. L$ a 2 _. X8 w, z- o. L$ a

" H! N V2 A m) F% r) B- vEND

" i2 c- {, B& R% o# N6 o文档君的AI幻觉就介绍到这啦!是不是秒懂了“AI幻觉”?

! Y- c* }" J; N U r

* I/ Y- o/ `# K所以下次当你的AI应用开始“梦话连篇”,不要“嘲笑”它,也不要急于按下“重启”键。5 K! s' K1 k0 G0 [

其实,AI也是在学习中成长的“小朋友”,它们在努力成长,可能偶尔也会开个小差,做个“白日梦”。只要我们用正确的方法引导它,多用一点耐心教导它,它就能从“梦游”中醒来,为我们提供准确、可靠的服务, ^, [) I2 B8 k8 E+ d/ j

! i% e) h( Y; f2 N/ V4 H ! i% e) h( Y; f2 N/ V4 H

~~~

8 ~3 E+ O0 V/ P: L! u3 W7 J' ~1 c8 D9 y& x, E% {

小问答& I0 R3 G3 l( h' x T% _

请问“林黛玉倒拔垂杨柳”属于AI的哪一种幻觉呢- X3 v+ D- }6 G9 p% [

. z( p! F" ], N9 a?还有没有什么典型的AI幻觉的例子?评论区跟大家分享一下吧~

' V( H* L) i4 N& O% _# k

' p5 T0 ]' T4 f1 b+ P% D/ j c+ ]4 z5 f; v* D4 h

|