最近,马斯克的人工智能初创公司xAI发布了他们最新、最出色的人工智能模型Grok 2。Grok 2是一个大型语言模型,根据行业基准,它是目前市场上最好的语言模型之一,这也被证明是马斯克迄今为止最成功的项目之一。(文末领取2024大模型实战课)

" Z+ h' P7 d3 U1 h% T4 H! BGrok-2的推出,以及其在多个领域的应用前景,标志着LLM技术的又一重要里程碑。这次我邀请了沃恩智慧联合创始人Kimi老师,给大家解读Grok的起源和背景、技术深度解析、Grok的应用场景、 多模态能力展示、开源社区和未来展望。, ]8 b' O7 W* N8 R/ H- H" D( x

扫码免费预约直播

% w& j. b4 j' d7 e9 D# j( E领大模型论文700篇5 A* r) ]8 C4 I0 U7 H+ D

ufu313u5nz364017460112.png

3 Z$ w# K, d( X% p7 e# }. S4 c

sngitomfnt364017460212.jpg

3 K) I1 |" F1 h% T) e4 G$ _& K' } {5 O3 w

Grok; M) B' Z0 g* j

Grok模型拥有3140亿个参数,是迄今为止参数量最大的开源模型,这使得它在处理复杂任务和生成高质量文本方面具备了更强的能力;Grok模型采用了混合专家(MoE)架构,这种架构通过将模型分解为多个子模型(专家),并在处理不同任务时激活相应的专家,从而实现了在保持模型性能的同时降低计算成本 。Grok是一个多模态模型,它不仅在处理文本方面表现出色,还能理解和处理广泛的视觉信息。Grok与X平台(原Twitter)的深度整合,使得Grok能够提供更加个性化和实时的服务,这也是其成为热点的原因之一。

$ w9 U& g2 n6 M" A4 W, e1 W. m( F, a目前国内已备案的大模型公司就达183家,马斯克也在田纳西州孟菲斯的xAI 新超级计算工厂启动了一个功能更强大的超级计算机集群。紧追大时代的必要之一就是了解背后的技术逻辑,这也是我邀请kimi老师来讲解Grok的原因。" ]$ t: g0 c- X7 w" v

" s- X; I8 J. }: j j( c! r" u

本次课程大纲:6 Y7 h# H4 D/ h8 W+ U% V6 V; f

1.Grok的起源和背景

# j: X4 G$ l$ p2.Grok技术深度解析5 [9 {# r+ M) D5 m

3.Grok的应用场景

. m _6 g: a% g4 ~4.多模态能力展示) z3 c \% P% Z# ?! b

5.开源社区和未来展望7 c7 ~, N4 y2 F. C7 `: H

* F- p4 s) a8 m. }2 t" ?

ih0on3wush464017460312.jpg

2 H" L' x, C& U9 g E

2 H" L' x, C& U9 g E

! J1 |* ~0 m5 J

立即解锁公开课

; P( z: W$ A0 L3 t3 {9 Z+ g3 r+ \# ~, P- a( i

( Q) w/ G; R+ X1 r& \6 k3 y

LLM# Q; D3 w* w% J1 a l* Y

大型语言模型(LLM)的发展呈现出多方面的进展,在技术层面,LLMs正在向多模态能力发展,例如OpenAI的GPT-4和Google的Gemini模型,这些模型可以解释文本以及其他媒体格式。LLMs也在被更深入地集成到企业工作流程中,例如客户服务、人力资源以及决策工具。同时,对于伦理AI和偏见缓解的关注也在增加,公司越来越重视在LLMs的开发和部署中实现伦理AI和偏见缓解。LLMs的发展正朝着更大规模、更专业和更安全的方向发展,同时也在探索如何更好地集成到各种业务流程和应用中。

0 H" U5 M& u; T4 U

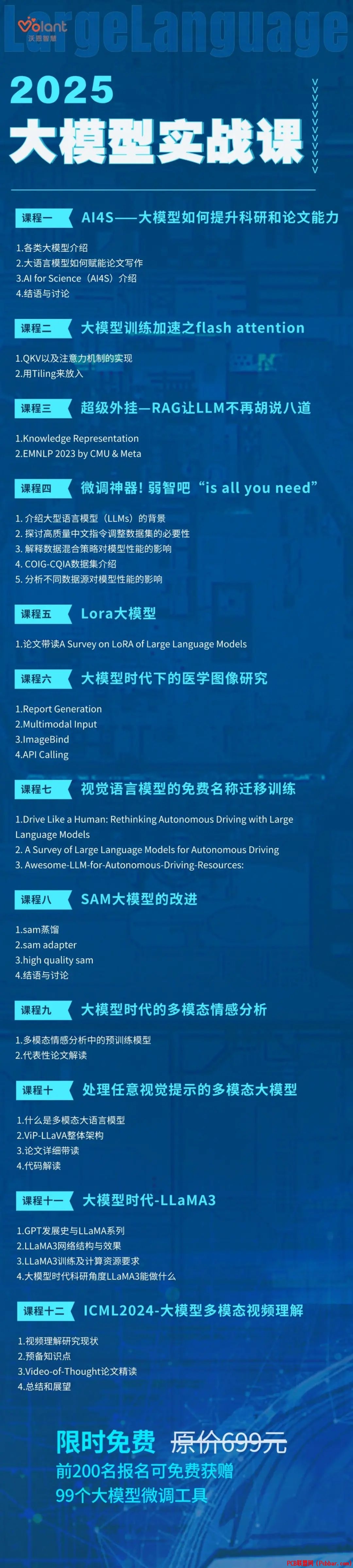

M5 e( _1 O k+ w, m# }/ c所以我联合多位QS前50大佬在2024年做了最新的大模型实战系列课,原价699元,现在0元领取!6 P( H7 `) j n' p2 m u

" j$ Z7 H) S$ Z, j U扫码解锁2024大模型实战课+ U& k4 d* M3 l- c1 {

- D/ s1 i& B, x9 K1 K; ^( ]

( A1 m1 k8 q7 F n9 {

/ D' k/ P' A$ e) d# J r' ~; [4 A

5is2fclvacs64017460412.jpg

7 w6 T( x. Y7 i5 i7 I

; f! m8 h! f& d( a8 y, [8 o

( [3 i; P2 g) `0 q6 s6 L对于想要发表论文,对科研感兴趣或正在为科研做准备的同学,想要快速发论文有两点至关重要

- Q$ p+ \; T# G2 V0 G$ G T

3 F7 l1 k. u( W& f1 Y X6 b, u对于还没有发过第一篇论文,还不能通过其它方面来证明自己天赋异禀的科研新手,学会如何写论文、发顶会的重要性不言而喻。

. }8 ?" b/ Q0 }9 V; B! h2 }( ~" D2 X$ o1 {

发顶会到底难不难?近年来各大顶会的论文接收数量逐年攀升,身边的朋友同学也常有听闻成功发顶会,总让人觉得发顶会这事儿好像没那么难!

6 L$ h$ e2 H1 B但是到了真正实操阶段才发现,并不那么简单,可能照着自己的想法做下去并不能写出一篇好的论文、甚至不能写出论文。掌握方法,有人指点和引导很重要!

6 z0 p+ Z2 Q2 }3 Q+ l( Y% D还在为创新点而头秃的CSer,还在愁如何写出一篇好论文的科研党,一定都需要来自顶会论文作者、顶会审稿人的经验传授和指点。

2 M9 r9 g4 K' r5 }9 [5 g) B, w很可能你卡了很久的某个点,在和学术前辈们聊完之后就能轻松解决。

* I, l- D4 K+ D! d; H$ H扫描二维码与大牛导师一对一meeting3 o& n* P: |# h4 ]( t

2 D( T& [2 w/ |! w, [5 K! e o; Q

; A# v" C9 ^! E/ K文末福利: j0 z0 k1 m$ c& Y2 |' D6 ^

7 B3 X f3 y1 [5 _6 c

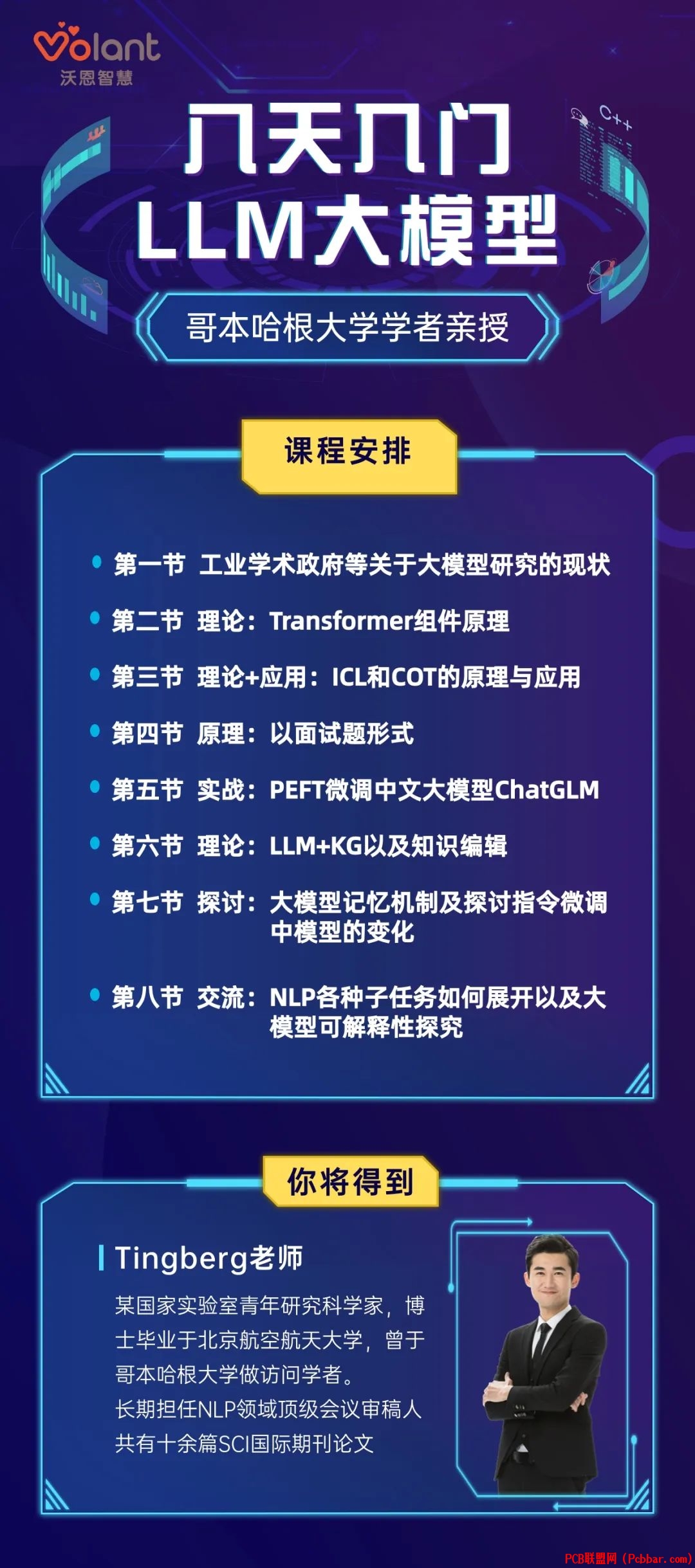

0 Q B7 q& o( `: b& b大模型正在以前所未有的速度重塑我们的工作和生活方式。这次我联合哥本哈根大学学者开了「大模型应用八日集训班」,以免费课的形式,带你体验 AI 创造之奇和提效之妙。并且还有一项福利:学完后送你一个99个大模型微调工具。哥本哈根老师亲授# y# A8 w( R" Y! Q2 \! W

8天掌握大模型+ l0 j4 k8 A. O7 d

课程目录:

0 c" S0 C6 o: U第一节 工业学术政府等关于大模型研究的现状

( s8 a1 _5 h, p) J& ]7 N第二节 理论:Transformer组件,原理第三节 理论+应用:ICL和COT的原理与应用第四节 原理:以面试题形式第五节 实战:PEFT微调中文大模型ChatGLM第六节 理论:LLM+KG以及知识编辑第七节 探讨大模型记忆机制及探讨指令微调中模型的变化第八节 NLP各种子任务如何展开以及大模型可解释性探究1 q! Y* T4 S7 @7 v8 B% U, n: C; I* W7 u

* A! X, H, Y6 W/ q- ?+ h9 p% k

kxl1c2wstmv64017460513.jpg

T" `+ O! h* K" F( w9 x* M! N

T" `+ O! h* K" F( w9 x* M! N

/ Y) z- [3 s& l4 H4 F7 E$ j本次系列课是歌本哈根大佬亲自录制,来跟我一起白嫖呀↓↓↓

( q. S$ e- o, J# V4 \. b& D0 O* F+ L! ^/ `0 {

|