|

|

引言

( v+ E. @) E$ ^+ y1 J6 C光计算代表了超越传统电子系统限制的最有希望的途径之一。随着摩尔定律和丹纳德缩放达到其基本限制,研究人员一直在探索能够提供日益复杂的人工智能工作负载所需计算能力的替代技术。本文研究了一种突破性的光子人工智能处理器,该处理器成功执行了具有接近电子精度的高级神经网络,标志着后晶体管计算技术发展的重要里程碑[1]。

9 H) K5 I0 w, ~9 m

m1el2t41n3c64012023627.png

) {9 a" u% H) I2 }4 F+ f3 \8 `

) {9 a" u% H) I2 }4 F+ f3 \8 `

: p/ s9 \+ {2 s; R, B; ^' x

1

) D3 O7 m$ U: X3 B' A' H后摩尔定律时代的人工智能计算挑战7 `1 \7 D8 F+ s! d) P+ b6 J

人工智能模型复杂性的指数级增长—包括大型语言模型、强化学习算法和卷积神经网络—已经将电子计算系统推向了物理极限。传统计算依赖于晶体管不断微型化来提高性能,但物理约束使进一步的进步变得越来越困难。/ Y" @4 O' f% W5 y

0 r) }! S, j# t9 u1 O3 p

光计算提供了一个引人注目的替代方案,利用光的内在特性:高带宽、低延迟和能源效率。这些特性使光处理器特别适合形成现代人工智能系统基础的张量运算。

6 [& N/ F; l1 R* O, }4 H/ x- C) h7 u4 D3 e* h& |' p

尽管过去十年取得了显著的研究进展,但先前的光计算演示在几个关键挑战上遇到了困难。实现实际人工智能应用所需的精度一直是一个特别棘手的问题,大多数系统未能匹配电子同类产品的计算完整性。此外,先前的演示通常仅限于简化的基准任务,而非复杂的实际应用。许多系统还面临将组件技术整合到完整功能系统中的困难,以及确保与高级人工智能架构兼容的问题。# t4 R7 i I7 x9 e: ?3 I' q# U

* N X2 ] A( O7 s; Q: B( ~1 M" b5 Z

本文描述的光子处理器解决了这些挑战,成功执行了包括ResNet、BERT和DeepMind的Atari深度强化学习算法在内的最先进神经网络,精度接近32位数字浮点系统。

8 Q/ s% j8 n P: k) Q7 T# k5 c3 f& |' g. e0 o- v, x9 @ @

20 y8 \. |2 B' m2 X2 F, Q0 g

光子处理器架构和设计

" @9 ^1 j9 ]9 a5 M. {光子处理器在单个封装中集成了六个芯片,利用垂直对齐的光子张量核心(PTCs)和控制芯片之间的高速互连。; p" v, H7 D$ I1 @6 M1 T% W

qmmnmqc4del64012023727.png

) V$ L- M4 l# T: R

) V$ L- M4 l# T: R

图1:(a)带有四个PTCs和12根光纤阵列的PCIe卡上的光子处理器照片。(b)封装架构渲染图显示集成散热器、两个12纳米控制chiplet和四个90纳米光子chiplet。(c)12纳米数字chiplet的平面图,显示输入输出接口、存储器、RISC核心和数据转换器。(d)光子chiplet的平面图,显示权重传输接口、向量单元和权重单元。2 B( ^3 a/ B' y

& F2 F7 v% j2 C% z* G+ ^. \; c

如图1所示,该处理器由四个128×128光子张量核心(PTCs)组成,这些核心使用GlobalFoundries的90纳米光子技术制造。每个PTC占用14.00×24.96毫米,包含运行所需的所有光子组件和模拟混合信号电路,除了高速模数转换器(ADCs)。这些ADCs包含在两个使用GlobalFoundries 12纳米工艺制造的数字控制接口(DCI)芯片中,每个尺寸为31.4×25.0毫米。DCI芯片结构庞大,每个含有250亿个晶体管。( o9 Y( K2 s6 `' r# @- O9 |) J

) ]/ P* F* Y8 `" Y' _: O这种创新封装将这六个芯片组装在一个54×56毫米的有机中介层上,上面是两个全掩模DCI芯片,下面是四个PTC芯片。这种垂直堆叠方法通过中介层顶部和底部层上的高密度穿孔,实现了芯片之间的直接通信,同时最小化了通道损耗。

8 Z( Y6 w, E; o+ B; M# n% d$ j3 N" r, u& e; z9 c+ J

DCI的平面图包括64个精简指令集计算机(RISC)核心,使用四核32位RISC-V SiFive E76-MC复合体实现。这些核心配合268MB统一缓冲区,用于存储激活、权重参数和其他数据。该统一缓冲区横跨控制芯片并管理几个并发内部传输,达到高达2,048 GB/s的速度。

0 D' R9 w: l! X& k- V' ?% w& l

W! ?3 J$ W$ ?4 s, I! ePTC平面图关于y轴进行了镜像处理,使两个PTCs匹配一个DCI,优化了系统的物理布局。每个PTC包含128个10位光子向量单元和128×128个7位权重单元,这些单元共同构成了处理器的计算核心。

4 [0 s+ P5 v; [4 Q8 E6 r+ @5 `& I' q& n, l9 y

3, Y! P& ^, R8 S" e

执行模型和数字架构 {& ^& L! O" q1 @: T; @7 f

处理器采用了一种复杂的执行模型,有效协调其各个组件之间的操作,实现高性能人工智能计算。! x* O7 U* o) d1 _

afoiplgb2ak64012023827.png

$ ] s8 l9 D% X% ~2 g图2:(a)光子处理器方框图,包括PCIe 4.0接口、统一缓冲区、RISC处理器、可编程激活函数和PTCs。(b)软件执行模型。主机处理器通过PCIe与光子处理器通信,发出指令并传输数据。(c)光子处理器中的数字表示。(d)增加增益允许ADC读取低位,如高亮显示所示,而高位可能饱和。

8 i2 d% `( D, I( z+ @) r" s3 P+ B \8 U* l) {

图2a中的方框图说明了DCI与PTCs的集成。在这种架构中,RISC控制代码和设备指令集架构(ISA)通过PCIe Gen4 x16总线从主机系统传输到共享内存。这个内存可由RISC核心和专用硬件指令排序器(图中标记为CTRL)访问。CTRL模块运行NuttX,一个为嵌入式系统优化的开源实时操作系统,它能够高效执行校准程序和其他控制操作。

& h! {2 x7 ?! a2 O

7 {- L2 Z( f1 e2 B% W( c6 j) }指令排序器通过实时命令网络向各个子系统发送命令。每个PTC执行128×128矩阵-向量乘积(MVP),从统一缓冲区中提取权重并以惊人的1,024 GB/s速度将它们传输到张量核心的权重接口。为了维持不间断的数据流,系统使用双缓冲权重,在MVP计算期间实现新权重的连续流式传输。6 r- P, u! }! r

/ Y1 X6 K3 I' N- o1 t4 Y0 i集成的输入和输出管道每个周期处理和输出128个元素的向量(每个256 GB/s)。有效权重的调整,具有约10纳秒的稳定时间,与数字管道延迟对齐以最大化效率。输出管道还支持读-修改-写操作,将张量核心输出累积到统一缓冲区中。

2 d+ H/ C1 A3 @

% M6 [. J K8 G神经计算引擎(NCE)作为128路单指令多数据(SIMD)加载/存储流处理器运行。它在16个矩阵寄存器(每个持有128个向量,每个向量有128个元素)和16个向量寄存器(每个持有一个128元素向量)上执行bfloat16操作。以256 GB/s的速度并发操作几个执行流,NCE使用矩阵寄存器作为临时数据存储的中间FIFOs。约简在bfloat24中进行,而非线性函数通过灵活的分段线性查找表执行。额外的64个RISC-V核心支持NCE不能原生处理的操作,主要协助PTC校准。

. a e. e6 `! o

1 {* }, G( x; n1 Q$ R图2b中展示的软件执行模型将PyTorch或TensorFlow中定义的神经网络转换为三个组件:一个主机x86二进制文件,协调跨多个设备的网络执行并处理指定给主机的操作;一个与嵌入式操作系统接口的RISC-V二进制文件,促进ISA执行和片外直接内存访问(DMA)等操作;以及由指令排序器处理的ISA指令。Python绑定在主机x86代码之上封装网络执行,提供类似PyTorch的接口以便于使用。

7 E7 B( `& I+ E6 w/ M! K+ e6 |% |" ~7 [ m+ t& R0 Q, `

在加载时,训练好的权重被传输到统一缓冲区,而RISC-V程序和ISA则加载到控制平面内存中。大多数ISA指令遵循类SIMD的流式结构,能够处理动态数量的向量。为了并行执行较长的指令,编译器为ISA分配依赖标签,允许排序器乱序执行指令以达到最大效率。

2 X* n! G0 Y7 O' v% R

' h, }9 H: e! Y: k5 i46 w& n3 s1 ?% y9 W

数字表示和精度

, D) y+ k* B1 d" N; Y- N处理器设计中最关键的方面之一是其数字表示系统。如图2c所示,光子处理器中的权重和激活以自适应块浮点(ABFP)格式表示,平衡了计算精度和硬件效率。

8 ^; \0 }$ ?- L; g. \ ~4 @" s" ^! C$ J. E% @* n

在这种方法中,NCE中的权重和激活首先以bfloat16格式表示。在准备PTC中的张量操作时,这些值通过将每个128元素向量除以该向量中最大条目的绝对值来转换为ABFP。这意味着每个128元素向量共享一个单一的bfloat16缩放因子:权重的sw和激活的sx。$ C1 G- m- N, _

- L! ]% ]1 G& e' r) K& ~规范化后,向量被量化为单元单元的位精度:权重为7位,激活为10位。然后在PTC中进行矩阵乘法,转阻抗放大器(TIA)对输出应用增益。ADC读出11位,输出通过乘以两个缩放因子sw×sx缩放回bfloat16。( g9 d' d0 D5 [0 S

2 _( ]9 S- _. c

当要乘的张量大于PTC的物理尺寸时,部分输出以bfloat16存储,并通过输出管道中的累积支持减少为最终输出。重要的是,ABFP仅用于涉及PTC的操作;所有其他操作—包括非线性和累积—使用bfloat16执行,以保持网络的准确性。6 D" t: S* U( `

$ g7 c" ]6 f" d$ _8 C5 _2 R( M

如图2d所示,增加系统增益允许ADC读取低位,尽管这可能导致高位饱和。该示例显示总共24位输出(源自7位权重、10位激活和每个向量元素128个元素的累积)。

2 K2 b1 u& U F5 `/ L. P) _% C! r+ `( H4 |% E

5

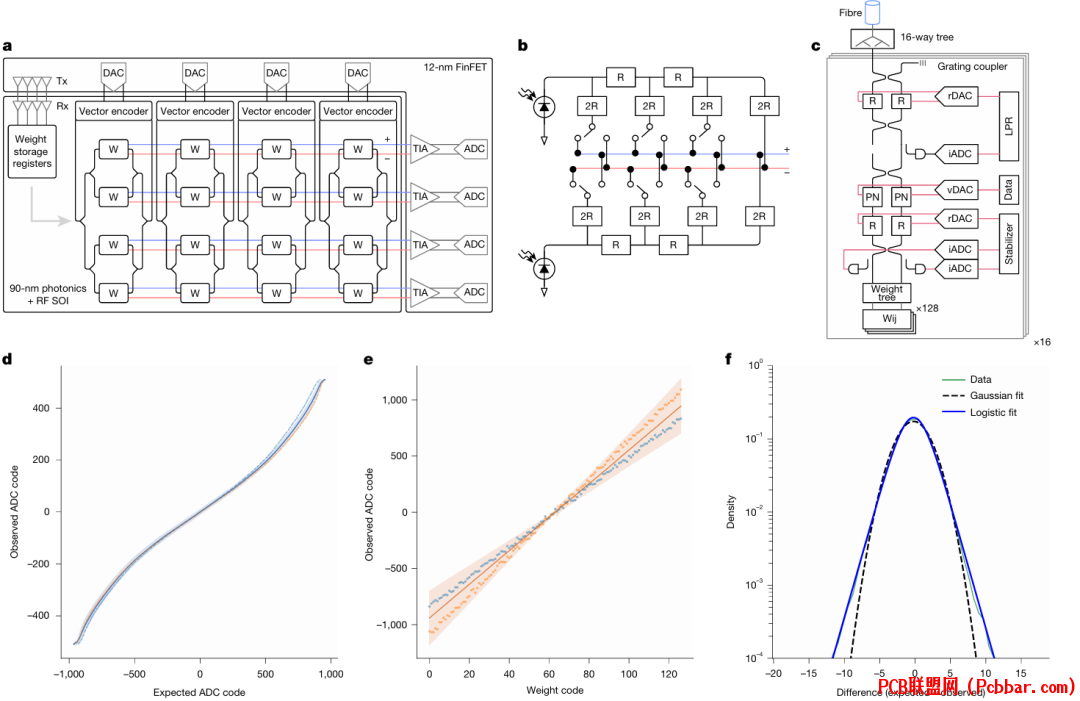

' {: @. |0 A- A. G9 c4 t+ |光子张量核心架构

* M5 H! a. M4 w# h! m0 F- ?8 d6 h! Q* ]光子张量核心(PTC)架构代表了光计算能力的重大进步,特别是在高效运行数据依赖的人工智能模型(如变换器)方面。

8 D1 F# t- e4 l3 ^; ?) R

rtiqeed2qbb64012023927.png

7 Z2 _8 Z9 L2 h9 ~, A图3:(a)微型4×4 PTC的PTC架构。(b)权重单元由连接到电阻差分DAC的差分光电检测单元组成。显示了3位电路示例。(c)向量编码器单元由MZI和温度稳定反馈环组成。光栅耦合器用于晶圆测试。(d)光子处理器中的向量编码器的测量线性化函数,用作查找表以规范化非线性,两个随机选择的向量编码器线性化函数绘制为虚线。(e)光子处理器中4,096个样本单元的测量权重单元传递函数,两个随机选择的传递函数绘制为点。(f)在bfloat16中从正态分布采样的向量和权重的4,096个预期和观察到的MVP之间的归一化误差分布。1 g3 j' A$ o F9 H f* |1 x: u

2 A6 B) }6 r" f+ {9 T6 r

图3a说明了一个微型4×4示例阵列的PTC架构。许多先前的光子人工智能处理器架构无法有效运行数据依赖的人工智能模型,其中下一组权重取决于前一次计算的结果。此类模型要求权重编程速率和向量编程速率之间的对称性,同时保持一定程度的权重静态性。PTC的架构选择通过平衡权重和向量编程速率来解决这些挑战,以有效进行数据依赖的人工智能计算,同时最大化计算密度。+ ]' I4 w g: q* g3 E

( V" b$ ?8 H# C# W在这种架构中,差分向量编码和分布在光子域中执行,权重端点实现为混合单元单元。求和通过差分金属线上的电流加法进行。高速数据转换(包括数模和模数)和放大在DCI中执行,利用高性能12纳米晶体管工艺。同时,张量操作、稳定化、本地寄存器存储和监控在PTC中进行。

" m8 @1 T% D V% a( X/ s: w& J

1 }7 Z' O6 |1 S" M% |/ X! U5 |9 P权重通过权重传输接口传输,这是一个3D堆叠的电子互连,在封装中PTC直接位于DCI下方。图3b中描述的权重单元由连接到7位分段二进制/R-2R梯形基电阻数模转换器(DAC)的差分光电检测器组成。这种配置实现了0.4个最低有效位(LSBs)的积分非线性,0.08 LSBs的差分非线性,以及1.5 GHz的带宽。

+ a6 O1 z. ~" H( ~. y+ A$ e5 p5 w/ c( A- E5 I, y+ A0 d. K

数字权重代码设置开关,有效地将输入光电流(代表激活)乘以或缩放为-1和+1之间的数字。每个权重单元都有一个可编程斜率参数,可以针对制造误差进行校准。图3e显示了带有±1标准偏差阴影区域的PTC的平均权重传递函数。极端处的饱和归因于ADC前的TIA中的非线性,而中间代码(零值)的误差通过设计最小化,反映了深度学习中权重张量通常围绕零的分布。

d6 s. }/ K7 L' ]# N

4 n/ e _9 `! U1 d, S. a如图3c所示,向量数据通过使用10位伪差分电阻DAC调制到基于p-n结的马赫-曾德尔干涉仪(MZI)上。DAC采用分段架构,6位通过R-2R梯形进行二进制加权编码,4位使用温度计编码。它可以以高达2 GHz的更新率运行,有效位数(ENOB)为8.3,在72 mW功耗下提供3.2 Vpp差分输出摆幅。1 e4 O% @+ l. K9 O

8 p# k& ]1 C: k8 |# t% x: g

为了考虑热漂移,MZI使用1%抽头监控光电检测器、双斜率积分ADC和逻辑反馈控制器进行稳定。光通过16路光子二叉树传递到向量调制器,使用激光功率调节器将输入功率调节为在LSB的一小部分内保持恒定。图3d显示了带有±1标准偏差阴影区域的向量调制器的平均传递函数,非线性归因于MZI的正弦传递函数。; t [! y- O7 C1 n- A+ _

% u& I5 u; O# z3 O0 g

一个可编程转阻抗放大器(TIA)处理输出信号。它由基于CMOS反相器的伪差分并联反馈TIA前端和Cherry-Hooper主放大器组成。这个TIA具有2.8 kΩ的标称转阻抗增益,0.8 GHz的带宽,0.4 μArms的输入参考电流噪声,1.5 Vpp的最大差分输出电压摆幅,以及41 mW的功耗。+ K& _" |: d7 g( Y1 e

0 [$ {' k4 g0 m9 f8 m

TIA后跟一个4×时间交错、两级流水线连续逼近ADC。第一流水线阶段解析前四个(最显著)位,第二阶段解析九位,阶段之间有冗余位以提高准确性。这个11位ADC以高达2 GSPS的采样率运行,ENOB为9.8位,功耗为66 mW,设定了PTC的峰值张量乘法率。$ V! M G3 l5 z# f# I+ g

; K# O! M3 M; E4 M+ u% Y6

/ [- h* y5 b q8 S! u$ d+ i; S. I) S人工智能工作负载执行性能

' Q0 T! k9 k3 ?! K0 B* B: W2 V% h光子处理器成功执行了各种复杂的人工智能工作负载,在许多情况下达到了与传统数字系统相当的准确度。

; `# v+ @, W5 M9 L. Z+ u

mib05eghb3264012024027.png

9 t4 k/ c. @% C. K o: @# z( G/ ~

9 t4 k/ c. @% C. K o: @# z( G/ ~

图4:(a)用于训练SegNet的Oxford-IIIT Pet数据集样本和分割示例,以及处理器的分割结果。(b,c)在光子处理器上运行的Atari Pacman和DQN Atari Beamrider。(d)光子处理器在执行BERT-Tiny进行IMDb情感分析任务时执行的样本情感分析。示例说明了模型准确分类电影评论为正面或负面情感的能力,展示了其在此任务中的熟练程度。(e)光子处理器执行NanoGPT在TinyShakespeare文本生成任务上生成的样本文本。文本展示了光子处理器生成类人文本的能力,突显了其对生成式语言模型的潜力。- R3 p( ^ V% I

3 L0 o* R9 n/ S1 a

图4展示了在光子处理器上执行的几个神经网络任务。图4a展示了用于训练SegNet的Oxford-IIIT Pet数据集样本,以及处理器生成的分割图。图4b和4c显示处理器使用深度强化学习算法运行Atari游戏—Pacman和Beamrider。图4d显示BERT-Tiny模型对电影评论进行的样本情感分析,而图4e展示了在TinyShakespeare数据集上训练的NanoGPT生成的文本。( E2 ?! V+ L* ]) [; Z/ |

, H L+ K B# q. `

研究人员系统评估了光子处理器在各种神经网络架构和任务上的性能,使用相同的模型权重和输入数据进行数字和光子系统评估,以确保一致性。线性和卷积模型,尤其是ResNet18,在不断增加复杂性的数据集上达到了与数字FP32平台相当的准确度水平。

1 C, t+ u5 {$ g! J+ r0 F

4 t+ A9 {7 |! ]0 K对于分类任务,光子处理器始终表现良好,在CIFAR-10上达到86.4%的准确率(FP32性能的97.8%),在Imagenette上达到79.3%(FP32的93.3%),在MNIST上达到令人印象深刻的99.3%(FP32的99.8%)。然而,回归任务由于对精确输出值的敏感性而显示出轻微的性能下降。在分类中,决策边界内的所有输出值都被视为相同的结果,使这些任务对噪声和轻微变化更具鲁棒性。

. `7 I8 Q* p5 V5 D3 _& L" O

7 p- A* ?5 t; p, A% L1 T! U* H+ B这种区别在BERT-Tiny变换器模型结果中尤为明显。该模型在IMDb分类任务上表现稳健,达到83.2%的准确率(FP32的96.5%),但在SQuAD问答任务上表现出显著降低的准确率,仅达到12.0%的F1分数(FP32的27.5%)。SQuAD任务代表了一个面向回归的问题,需要更精确的输出,使其更容易受到光子计算噪声特性的影响。

9 j p( p+ i7 ?9 k d+ [9 n4 K0 ]+ |+ E+ G8 k

对于强化学习任务,光子处理器成功地玩转了Atari游戏环境,如Beamrider和Pacman,尽管性能低于FP32水平。具体来说,Beamrider在光子处理器上运行了6,430步,而在FP32处理器上运行了30,304步;Pacman在光子处理器上运行了1,825步,而在FP32处理器上运行了3,329步。强化学习任务中这种降低的性能反映了顺序决策过程中积累的错误,早期步骤中的小不准确可能导致后期步骤中的更大偏差。( C1 s9 @' H$ r

' B2 y6 @! C# B. _3 m研究人员将准确度下降主要归因于光子处理器中由于向量编码器电路中硅波导的非线性吸收而导致的有限光功率。硅波导仅用于需要热光调制或高速调制的芯片区域,其他波导路由在氮化硅中进行。这种非线性吸收将系统增益限制在1.86,明显低于设计目标增益4。较大的模型,如ResNet34,具有2170万参数(相比ResNet18的1160万),表现出进一步降低的准确性,归因于这种减少的增益。

4 t6 H% m/ J0 m' N. m0 I' N1 x# U2 Y1 o# e

此外,由于DCI时钟树未优化,工作负载以500 MHz的时钟速率执行,尽管处理器已证明能够以2 GHz的时钟速率运行(伴有间歇性错误),理论上能够实现每秒高达262万亿次ABFP16操作。& d( h0 V6 w4 \$ M# A- F& s

5 C; g( N! C1 U0 p

7* l8 x8 s- W C4 U% ^

通过神经网络优化提高性能. j9 e+ f- \ ^/ v9 @+ g8 _

研究人员探索了提高在光子硬件上执行的人工智能模型准确性的技术。量化感知训练和微调显示出处理模拟计算固有噪声和精度限制的巨大潜力。

% k$ o8 O8 B! y" H( K5 C

# l1 k* ^0 t6 i8 t1 ]5 j6 Q量化感知训练允许模型通过在训练过程中模拟量化效果来适应低精度表示。这种方法通常会产生更接近32位数字精度的性能,即使在低精度硬件上执行时也是如此。为了评估这种潜力,研究人员使用ImageWoof数据集重新训练了ResNet18,使测试准确率从64.4%显著提高到79.7%。8 i8 o- F/ H P k3 E

7 {$ k' s+ [" B* `8 V3 M/ H& i研究中的所有其他人工智能模型都是开箱即用的,没有任何重新训练或微调,表明在整个范围内都有显著的性能提升空间。这一结果说明了训练技术在光子计算系统特有的模拟噪声存在的情况下提高准确性的适用性。2 k+ p) Z! T! f/ `, L

- ]9 a4 U" r6 K6 J8 a0 }8 t' ?

生成模型,如NanoGPT,表现出由光子处理器计算中固有随机性引起的输出变异性。有趣的是,这种变异性与在类似约束下的数字硬件输出非常相似,表明模型本身的随机性主导了任何特定于硬件的变异性。9 V2 I, x; e4 t/ X5 C+ ^

3 A9 K1 C) P& c6 v P+ ]$ I1 j研究人员建议,微调和量化感知训练可能会进一步提高强化学习任务的性能,如涉及Atari深度Q网络的任务。这些技术可能使光子处理器处理更复杂的决策边界,并减少噪声对精确奖励预测的影响。鉴于对数值精度的敏感性,回归任务从这些技术中获益显著,因为这些技术将使对权重调整的更精细控制成为可能,并增加输出稳定性。

n+ C' m0 H0 j) S4 G

7 z) O. u& |* u, |( G0 U2 q84 m3 v0 s5 u7 m9 p4 [

未来方向和挑战" |( d% n% K( `! L

虽然光子处理器在计算能力方面代表了实质性进步,但该领域仍有几个需要解决的挑战和机会。9 m' u+ b* H! O: b# Z: K* r. T

% z5 j6 v7 ?( z1 \2 k1 c

当前的PTC占用350 mm2,不到全掩模芯片面积(通常为850 mm2)的一半。研究人员认为,通过利用先进的封装技术,如混合键合或微凸点,可以进一步减小PTC的占用面积,这些技术能够减少DCI和PTC之间的互连间距。这些变化可能将当前架构扩展到单个全掩模芯片中的512×512计算单元,PTCs和DCIs的3D堆叠使阵列远超过所展示的四核实现。

4 g- d( D& Q3 _

! B) P/ d6 J4 ?, `光子计算的能源效率与张量核心的大小成非线性关系,更大的核心提供更高的效率。然而,实现这一优势需要新的神经网络架构,旨在通过每次数据加载执行更多计算来最小化内存查找。这种转变可以大幅减少在数据移动和内存访问上花费的能量,解决针对图形和张量处理单元优化的人工智能系统中的主要瓶颈。5 z5 F! r: ^! V) b8 }2 @2 }5 Z

/ A) n' t5 e8 D* O& ^1 e2 X* Z; h- x

光子处理器架构还可以通过添加输入多路复用器和输出解复用器来使用波长分割多路复用来增强。这种方法提供了增加处理器计算密度的路径。+ O9 G( G- m6 l$ C7 \& i9 N

/ G1 B; G9 H" q G

一个明显的限制是更高时钟速率所需的光功率,这受到硅光子器件中非线性吸收的限制,特别是在p-n结和热光相移器中。未来的设计必须通过器件工程创新、自适应功率控制或补充硅性能的混合材料来克服这一限制。, m l" U: a+ [# w

1 l- G9 ~9 M2 o$ N

材料科学的进步对光子处理器具有变革性潜力。铌酸锂、钛酸钡和新兴的二维系统等新材料可以减少光学非线性,提高调制速度,并实现更紧凑的单元单元。这些创新有望提高计算能力、能源效率和可扩展性,为性能远超当前能力的混合光电平台打开大门。

( s' j( c- h; R# |) M# B8 Y2 Z4 }

这些挑战的跨学科性质需要光子技术、材料科学和机器学习领域的合作。解决这些障碍将推动光子处理器作为下一代人工智能硬件平台的发展。

0 L2 k8 w( f, S1 ~* @2 j, d; l) u5 V- u ]

9: Y+ n5 D( x6 f0 A

结论

' a0 i2 `8 b$ ]+ d5 p+ O1 K: o1 V2 Q( R本文描述的光子处理器代表了光计算领域在人工智能应用中的重大进步,展示了一个在复杂的开箱即用人工智能模型上实现接近数字精度和性能的系统。通过成功实现如ResNet和BERT等模型,并展示对强化学习算法的熟练程度,这款光子处理器标志着后晶体管计算技术发展的重要步骤。

$ n. _2 P: l, m- z3 d' j: q3 e* B) Y7 X, o

这些结果验证了光子技术作为传统人工智能加速器的竞争性替代方案的潜力,并为未来光子技术人工智能技术的发展奠定了基础。随着这一领域的研究进展,光子处理器可能在满足人工智能和机器学习应用日益增长的计算需求方面发挥越来越重要的作用,特别是随着传统电子系统接近其基本物理极限。

( [: {% z- z' G/ ], ?/ A9 j% }8 S( D, ? Q0 }. Y

在单个封装中集成六个芯片的集成水平代表了迄今为止最全面的光子处理器实现。这种集成水平,加上能够以高精度执行最先进神经网络的能力,使光计算成为后摩尔定律计算时代的可行技术。

3 ^# [1 l; j0 o* z4 T: J7 _ X' C8 H5 Z4 ?

参考文献

" Q* T, Z; f0 M) X' K" w: u) R3 F% `[1] S. R. Ahmed et al., "Universal photonic artificial intelligence acceleration," Nature, 2025, https://doi.org/10.1038/s41586-025-08854-x.( D/ [% l- t8 |) u% e: \2 K

END3 d, ^3 T/ y, c" c3 k5 f1 b

软件试用申请欢迎光电子芯片研发人员申请试用PIC Studio,其中包含:代码绘版软件PhotoCAD,DRC软件pVerify,片上链路仿真软件pSim,光纤系统仿真软件pSim+等。更多新功能和新软件将于近期发布,敬请期待!3 s$ x% ]/ D) ~# b' t! F; E' ^; d

点击左下角"阅读原文"马上申请* g9 L7 r0 G) y: q

* q8 s# b9 k8 j! a4 |- {欢迎转载

/ k4 D* E! z. D1 |0 x

, \4 `$ Q* ^4 z- E转载请注明出处,请勿修改内容和删除作者信息!) I9 L" {3 P6 {+ u, u

8 m, r" U" \( V& f3 k, T' D; A

' A3 t9 _3 L6 z1 p. m! `! K* z

$ ?* x7 _6 K. @9 V4 _ v* L8 v( o

z0f2vafucdd64012024127.gif

5 H$ f8 P0 p7 E4 Y/ {

5 H$ f8 P0 p7 E4 Y/ {

/ O; @- I& M+ N

关注我们 b( G/ T- i, b3 K, v; G) j

7 k' t; ~; @+ K1 N$ b k$ ]- S1 h& h$ N* {. G* D

yfvxdxdpjdn64012024228.png

2 T: ~, }7 C" ?! \

2 T: ~, }7 C" ?! \

| " j& u) `3 t- v# S5 [9 ^! f

xhgi0qr5woq64012024328.png

, @& a [/ i3 a9 Z

, @& a [/ i3 a9 Z

| 8 l' w h# u+ I7 _

iuumjsxakxp64012024428.png

/ N' N% Z6 p# u1 G

/ N' N% Z6 p# u1 G

|

) s2 F! A5 a- C# |3 C( `6 U9 [

$ @% D! L G) M! }0 S3 _; a

6 R; |# ~) n0 W$ H" u- V. {; G- M: \# ?' d( \

关于我们:

+ C% q. F3 [+ w" v深圳逍遥科技有限公司(Latitude Design Automation Inc.)是一家专注于半导体芯片设计自动化(EDA)的高科技软件公司。我们自主开发特色工艺芯片设计和仿真软件,提供成熟的设计解决方案如PIC Studio、MEMS Studio和Meta Studio,分别针对光电芯片、微机电系统、超透镜的设计与仿真。我们提供特色工艺的半导体芯片集成电路版图、IP和PDK工程服务,广泛服务于光通讯、光计算、光量子通信和微纳光子器件领域的头部客户。逍遥科技与国内外晶圆代工厂及硅光/MEMS中试线合作,推动特色工艺半导体产业链发展,致力于为客户提供前沿技术与服务。- m8 I" ^/ d; ~2 Z

! G& A5 R/ S' a2 h! g

http://www.latitudeda.com/: W- N! [( r1 c6 H

(点击上方名片关注我们,发现更多精彩内容) |

|